はじめに

ディープラーニング、3Dモデリング/レンダリング、VRゲーム、暗号マイニングなどの分野の人気が高まるにつれ、現代のコンピューティング要件は急上昇しています。コンピューティングパワーの提供を担当するハードウェアコンポーネントは、需要に応じて進化しました。この進化は、コンピュータシステムでの役割を区別することが困難な場合があるところまで到達しました。

この記事では、CPUとGPUの2つの主要なコンピューティングエンジンの包括的な比較を提供します。

CPU対GPU:概要

以下は、CPUとGPUの主な比較ポイントの概要です。

| CPU | GPU |

|---|---|

| 少数の大きなコア(最大24) | 多数(数千)の小さなコア |

| 低レイテンシ | 高スループット |

| シリアル処理用に最適化 | 並列処理用に最適化 |

| 複雑なプログラムを実行するために設計されています | 単純で反復的な計算用に設計されています |

| クロックあたりの実行命令数が少ない | クロックごとにより多くの命令を実行します |

| 自動キャッシュ管理 | 手動のメモリ管理が可能 |

| 小規模なワークロードのコスト効率 | より大きなワークロードのコスト効率 |

CPUとは何ですか?

CPU(中央処理装置)またはメインプロセッサが計算命令を実行します。 CPUソケットを介してマザーボードに接続されたCPUは、コンピュータプログラム、またはキーボード、マウス、タッチパッドなどの周辺機器からの入力をリッスンします。次に、入力を解釈して処理し、結果の出力を周辺機器に送信するか、メモリに保存します。

GPUとは何ですか?

GPU(グラフィックスプロセッシングユニット)は、何千もの操作を同時に処理できるように設計された特殊なグラフィックスプロセッサです。要求の厳しい3Dアプリケーションでは、画像を画面上でスムーズに移動させるために、並列テクスチャ、マッシュ、およびライト処理が必要であり、CPUアーキテクチャはこれらのタスク用に最適化されていません。 GPUの本来の目的は、グラフィックスレンダリングを高速化することでした。

CPUとGPUの違い

どちらもシリコンベースの処理チップですが、CPUとGPUはアーキテクチャとアプリケーションが大きく異なります。

CPU対GPUアーキテクチャ

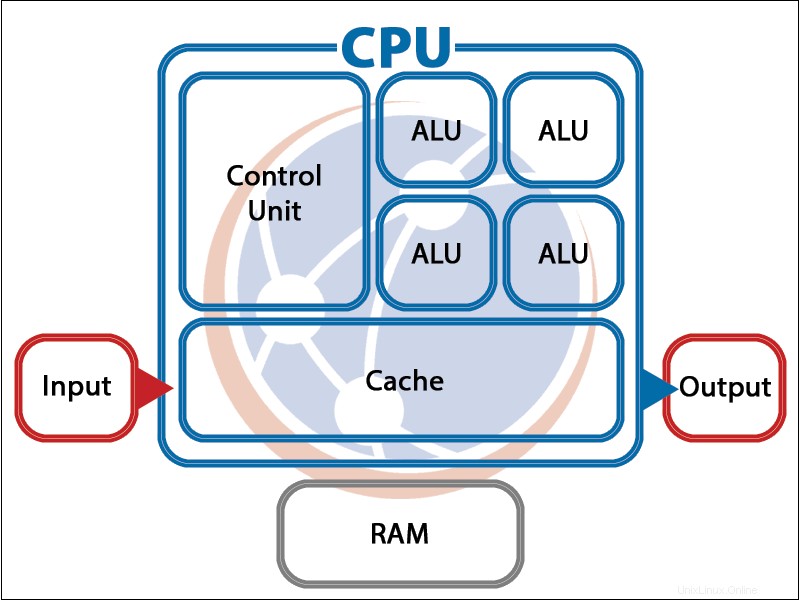

CPUは、論理ゲートを作成するために接続された数十億のトランジスタで構成されており、論理ゲートは機能ブロックに接続されます。大規模な場合、CPUには次の3つの主要コンポーネントがあります。

- 算術論理演算装置(ALU) 算術演算と論理演算を実行する回路で構成されています。

- コントロールユニット 入力から命令をフェッチし、それらをALU、キャッシュ、RAM、または周辺機器に転送します。

- キャッシュ ALU計算に必要な中間値を格納するか、実行中のプログラムのサブルーチンと関数を追跡するのに役立ちます。

CPUは、独自のALU、コントロールユニット、およびキャッシュを備えた複数のコアを持つことができます。

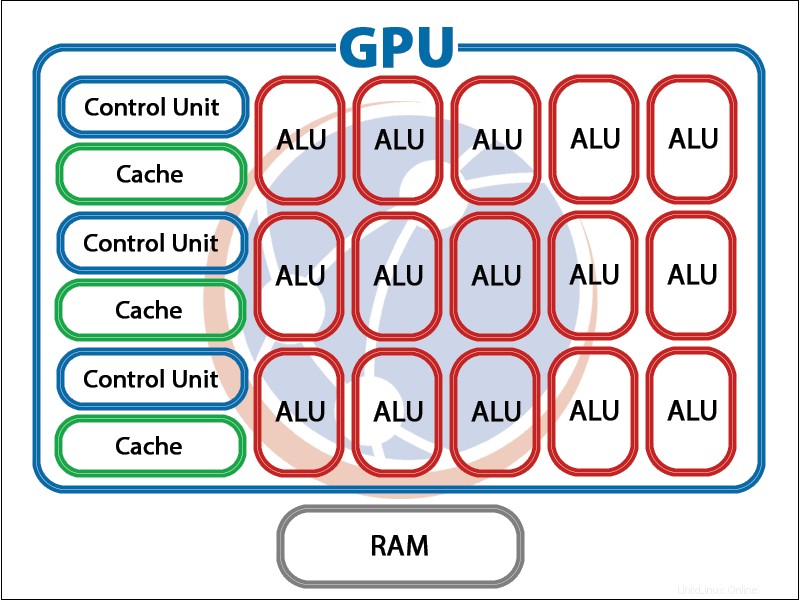

GPUは同様のコンポーネントで構成されていますが、非常に多くの小さな特殊なコアを備えています。マルチコアの目的は、GPUが複数の並列コンピューティング操作を実行できるようにすることです。 。

CPU対GPUレンダリング

GPUは主にグラフィック操作用に作成されたため、レンダリング速度がCPUよりも優れている理由が説明されています。個々のハードウェアの品質にもよりますが、GPUレンダリングはCPUレンダリングよりも最大100倍高速になる可能性があります。

ただし、優れたレンダリングエクスペリエンスは、速度だけに依存するわけではありません。たとえば、3Dビジュアルを操作するには、データの同期を維持しながら、複数の複雑なタスクを実行する必要があります。複雑さを考慮して設計されたCPUは、3DレンダリングでGPUを上回る傾向があります。これは、GPUがより単純でより単純なタスクを実行するように設計されているためです。

さらに、GPUはグラフィックカードメモリ(通常は最大12 GB)に制限されており、スタックせず、ボトルネックやパフォーマンスの低下を引き起こさずに簡単に拡張することはできません。 CPUは、簡単に拡張可能で最大64GBのメインシステムメモリを使用します。

CPUキャッシュとGPUキャッシュ

CPUはキャッシュを使用して、メモリからデータを取得するために必要な時間とエネルギーを節約します。キャッシュは、メインメモリよりも小さく、高速で、他のCPUコンポーネントに近くなるように設計されています。

CPUキャッシュは複数のレイヤーで構成されています。コアに最も近いレベルはそのコアによってのみ使用され、最も遠いレイヤーはすべてのCPUコア間で共有されます。最新のCPUは、キャッシュ管理を自動的に実行します。各レイヤーは、使用頻度に基づいてメモリを保持するか削除するかを決定します。

GPUローカルメモリは、構造的にCPUキャッシュに似ています。ただし、最も重要な違いは、GPUメモリが不均一なメモリアクセスアーキテクチャを備えていることです。これにより、プログラマーはどのメモリピースをGPUメモリに保持し、どのメモリピースを削除するかを決定できるため、メモリの最適化が向上します。

CPU対GPUディープラーニング

ディープラーニングは、GPUのパフォーマンスがCPUよりも大幅に優れている分野です。ディープラーニングでGPUサーバーの人気に貢献する重要な要素は次のとおりです。

- メモリ帯域幅 -GPUの本来の目的は、テクスチャとポリゴンの3Dレンダリングを高速化することであったため、大規模なデータセットを処理するように設計されました。キャッシュが小さすぎるため、GPUが繰り返し処理するデータ量を保存できないため、GPUはより広く高速なメモリバスを備えています。

- 大規模なデータセット -深層学習モデルには大規模なデータセットが必要です。メモリを大量に消費する計算を処理する際のGPUの効率により、GPUは論理的な選択になります。

- 並列処理 -GPUはスレッドの並列処理を使用して、データのサイズによって引き起こされる遅延の問題を解決します-複数の処理スレッドを同時に使用します。

- コスト効率 -大規模なニューラルネットワークのワークロードには、多くのハードウェアパワーが必要です。この目的のために、GPUベースのシステムはより少ない費用で大幅に多くのリソースを提供します。

CPU対GPUマイニング

GPUマイニングはより高価になる傾向がありますが、GPUのハッシュレートはCPUよりも高くなります。 GPUは、CPUよりもクロックあたり最大800倍多くの命令を実行するため、マイニングに必要な複雑な数学的問題をより効率的に解決できます。 GPUはまた、エネルギー効率が高く、保守が容易です。

CPUとGPUはどのように連携しますか?

2つを比較する場合、GPUはCPUを置き換えるのではなく、CPUを補完するように設計されていることを理解することが重要です。 CPUとGPUが連携して、処理されるデータの量と速度を向上させます。

GPUは、コンピューターシステムのCPUを置き換えることはできません。 CPUは、システムでのタスクの実行を監視するために必要です。ただし、CPUは特定の反復ワークロードをGPUに委任し、システムと実行中のプログラムの安定性を維持するために必要な独自のリソースを解放できます。