このチュートリアルでは、Ubuntu 18.04LTSにApacheSparkをインストールする方法を紹介します。知らない人のために、ApacheSparkは高速で汎用のクラスターコンピューティングシステムです。 。Java、Scala、Pythonで高レベルのAPIを提供し、実行チャート全体をサポートする最適化されたエンジンも提供します。また、Spark SQL for SQLや構造化情報処理、MLlibformachineなどの高レベルツールの豊富なセットもサポートします。学習、グラフ処理用のGraphX、およびSparkStreaming。

この記事は、少なくともLinuxの基本的な知識があり、シェルの使用方法を知っていること、そして最も重要なこととして、サイトを独自のVPSでホストしていることを前提としています。インストールは非常に簡単で、ルートアカウントで実行されていますが、そうでない場合は、' sudoを追加する必要があります。 ‘ルート権限を取得するコマンドに。 18.04 LTS(Bionic Beaver)サーバーにApacheSparkを段階的にインストールする方法を説明します。

Ubuntu 18.04 LTSBionicBeaverにApacheSparkをインストールする

ステップ1.まず、ターミナルで次のapt-getコマンドを実行して、すべてのシステムパッケージが最新であることを確認します。

sudo apt-get update sudo apt-get upgrade

ステップ2.Javaをインストールします。

Apache Sparkでは、サーバーにJavaがインストールされている必要があります。デフォルトでは、JavaはUbuntuのリポジトリで使用できません。次のコマンドを使用してOracleJavaPPAをAptに追加します。

add-apt-repository ppa:webupd8team/java apt-get update -y apt-get install oracle-java8-installer

次のコマンドを実行して、Javaのバージョンを確認します。

java -version

ステップ3.Ubuntu18.04LTSにApacheSparkをインストールします。

次のコマンドを使用してApache Sparkをインストールします:

wget https://www.apache.org/dyn/closer.lua/spark/spark-2.3.1/spark-2.3.1-bin-hadoop2.7.tgz tar xvzf spark-2.3.1-bin-hadoop2.7.tgz ln -s spark-2.3.1-bin-hadoop2.7 spark

パスにSparkを追加する:

nano ~/.bashrc

次に、これらの行を.bashrcファイルの最後に追加して、パスにSpark実行可能ファイルのパスを含めることができるようにします。

SPARK_HOME=/idr00t/spark export PATH=$SPARK_HOME/bin:$PATH

これらの変更を有効にするには、bashrcファイルに対して次のコマンドを実行します。

source ~/.bashrc

Spark Shellの起動:

./spark/bin/spark-shell

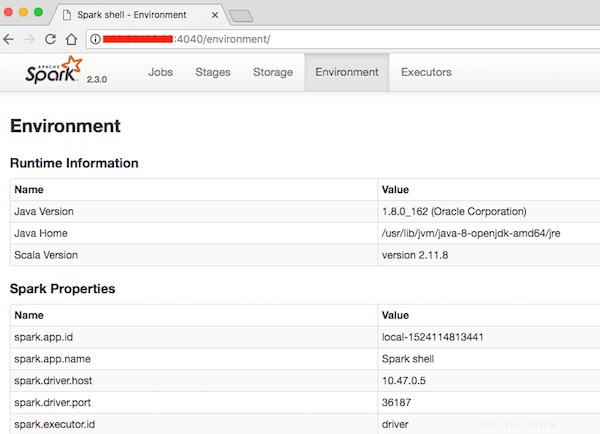

ステップ4.ApacheSparkへのアクセス。

Apache SparkはデフォルトでHTTPポート4040で使用できます。お気に入りのブラウザーを開き、http://your-domain.com:4040<に移動します。 / code> またはhttp:// server-ip:40404 インストールを完了するために必要な手順を完了します。

おめでとうございます!ApacheSparkが正常にインストールされました。このチュートリアルを使用してUbuntu18.04 LTS(Bionic Beaver)システムにApache Sparkをインストールしていただきありがとうございます。追加のヘルプや役立つ情報については、以下を確認することをお勧めします。 ApacheSparkの公式ウェブサイト。